Si GPT-3.5 avait 175 milliards de paramètres, GPT-4 en possède 100 billions. Hier soir, OpenAI a levé le voile sur son nouveau modèle de langage et en peine 24h, il a déjà mis tout le monde d’accord.

GPT-4 est là, et c’est complètement fou !

L’arrivée de GPT-4 n'était plus qu’une question de temps. Après la conférence donnée, la semaine dernière, par plusieurs ingénieurs de Microsoft Allemagne, nous savions que le nouveau modèle de langage révolutionnaire promis par OpenAI depuis plusieurs années allait débarquer au cours de cette semaine. Si beaucoup parlaient du 16 mars pour une annonce officielle, Sam Altman a finalement pris tout le monde de court en présentant l’évolution de son nouveau modèle deux jours plus (le 14 mars). Au travers d’un thread sur Twitter, ce dernier a tenu les propos suivants à l'égard de sa nouvelle technologie :

Voici GPT-4, notre modèle le plus performant et aligné à ce jour. Il est disponible aujourd'hui dans notre API (via une inscription à une liste d'attente) et pour les utilisateurs ChatGPT+. Il est toujours imparfait, toujours limité, et il semble toujours plus impressionnant lors de la première utilisation qu'après avoir passé plus de temps avec lui. Il est plus créatif que les modèles précédents, il hallucine nettement moins et il est moins biaisé.

Contrairement à ses prédécesseurs, GPT-4 est un modèle de langage multimodal, c'est-à-dire, qu’il est capable de générer des réponses dans des formats autres que le texte, comme la vidéo, l’audio ou même l’image. OpenAI précise aussi que ce dernier peut répondre à des situations plus complexes tout en formulant des réponses plus « humaines ». Le PDG d’OpenAI précise même que son nouveau bébé, aussi perfectible qu’il soit, est capable de « réussir l’examen du barreau ». En fait, GPT-4 est tellement puissant qu’il rend les examens traditionnels (presque) obsolètes.

GPT-4 est capable d’intégrer les écoles les plus prestigieuses du monde

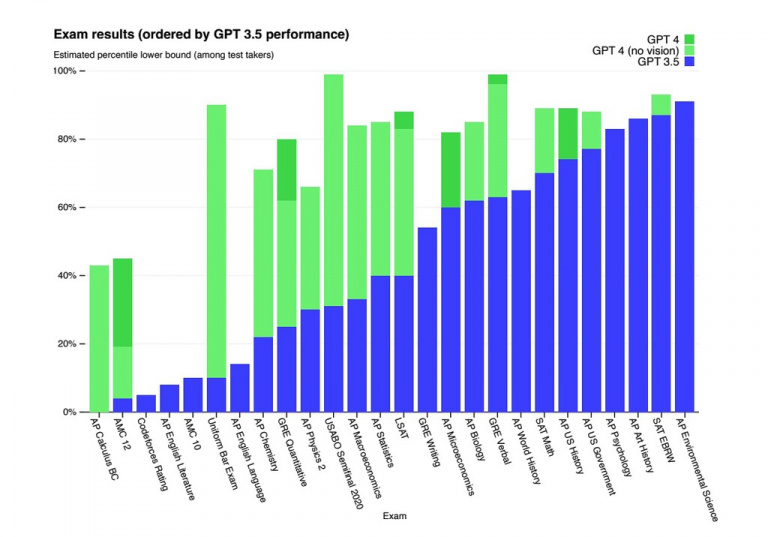

GPT-4 pourrait obtenir une place à Stanford. Sa capacité de raisonnement s'est suffisamment améliorée pour réussir la plupart des tests et examens du monde entier sans trop de difficulté. Si GPT-3.5 échoue aux tests de mathématiques et de langues les plus complexes, GPT-4, lui, les réussis haut la main. Pour prendre un exemple concret, si le dernier modèle de langage d’OpenAI était un étudiant et que nous le mettions dans une classe passant des examens traditionnels, il figurerait parmi les 10% des meilleurs élèves. A contrario, si on plaçait GPT-3.5 dans la même situation, il ferait, quant à lui, partie des 10% de ceux qui ont la plus mauvaise note. Et si vous doutiez de ces résultats, dites-vous que c’est OpenAI qui les a publiés en parallèle du lancement de GPT-4.

Crédit Photo : OpenAI

Dans ce dossier long d’une centaine de pages, la société explique que son nouveau modèle de langage a obtenu ses résultats sans formations spécifiques pour ces examens. Néanmoins, elle précise tout de même qu’une minorité d’entre eux ont été inclus dans les modèles de formation, tout en expliquant qu’à chaque fois, c’est le résultat avec le score le plus bas qui est pris en compte. Sam Altman et ses équipes précisent que GPT-4 parvient à réussir tous les types d’examens, que ce soient ceux avec des choix multiples ou ceux avec des réponses libres.

L’amélioration de ces modèles, au fil du temps, est inévitable. Mais la question n’est pas tant de savoir dans quelle mesure GPT-4 peut réussir ces examens, mais plutôt de savoir si la méthode d’évaluation est efficace. Cela avait d’ailleurs causé plusieurs problèmes dans des universités mondiales (et françaises) lors de l’essor fulgurant de ChatGPT. Toutefois, Gary Marcus, professeur de psychologie à l'université de New York et critique de l'intelligence artificielle, modère, toutefois, les résultats obtenus par le modèle, en expliquant que : « Obtenir de bons résultats à un tas de tests ne signifie en aucun cas que GPT-4 peut vraiment fonctionner comme un étudiant de Stanford ».