Le rendu HDR n'était pas vraiment au centre de la communication de NVIDIA lors du lancement des GeForce RTX, et pourtant, on ne le répètera jamais assez : cette technologie, lorsqu'elle est correctement exploitée, représente à elle seule un gain visuel considérable pour le joueur. Or, NVIDIA présentait un certain déficit dans ce domaine, par rapport à la concurrence. Un déficit que la marque a cependant comblé avec sa nouvelle génération de cartes.

De quoi parlons-nous exactement ? Tout simplement d'un article publié en juin dernier par nos confrères de Computer Base, qui pointait des baisses de performances sensibles sur les produits GeForce GTX lorsque le rendu HDR était activé sur certains jeux compatibles. Des pertes que l'on ne constatait pas sur les produits Radeon concurrents, et qui pouvaient monter jusqu'à 10% du frame rate selon les cartes et les jeux testés, ce qui est loin d'être négligeable.

A l'époque, nous n'avions pu nous pencher sur la question, mais le lancement de cette nouvelle génération de carte RTX était l'occasion de remettre les choses à plat à ce niveau et de voir :1- Si ces baisses de performances sont toujours d'actualité sur les GeForce de série 10 et 2- Si ces problèmes touchent également la nouvelle génération. Rappelons avant de parler chiffres en quoi consiste le rendu HDR : pendant longtemps, les images que nos écrans nous renvoyaient respectaient le format SDR. Ce format était encadré par différentes spécifications ayant trait à la profondeur d'échantillonnage, ou à la courbe de gamma de l'image. Problème : le rendu SDR ne couvre qu'une faible portion de ce que l'oeil humain est capable de lire en termes de nuances de couleurs ou de variations de contraste, et par ailleurs, les technologies de captation de l'image ayant largement évolué, il représente aujourd'hui un nivellement par le bas de la qualité des contenus pour le consommateur final. Aussi depuis quelques années, l'ensemble de l'industrie pousse pour la généralisation d'un format plus qualitatif pour les afficheurs modernes, le HDR. Avec ce nouveau standard, nous devrions profiter de couleurs et de contrastes autrement plus nuancés que ce que le format SDR propose aujourd'hui. Et si l'on se base sur les différentes démonstrations auxquelles nous avons pu assister ces dernières années, nous ne pouvons que confirmer cette assertion : difficile de revenir en arrière une fois qu'on y a gouté, tant l'image SDR parait délavée en comparaison de son équivalent HDR.

Maintenant, aussi intéressante soit elle pour le joueur, la mise en place du HDR n'est pas une chose facile. Pour qu'elle soit efficacement exploitée en jeu, cette forme de rendu nécessite une intégration à différents niveaux : au niveau du système d'exploitation, au niveau du jeu lui-même, au niveau de l'afficheur, comme au niveau du GPU. Et chacun de ses aspects dépendant d'un ou plusieurs acteurs industriels, il y a un vrai défi à relever pour s'assurer que tout le monde travaille bien dans la même direction. C'est du reste ce qu'il était ressorti de notre dernière expérience en matière de rendu HDR : en fonction des jeux, le support de ce format d'affichage était d'une qualité variable, sur PC tout du moins.

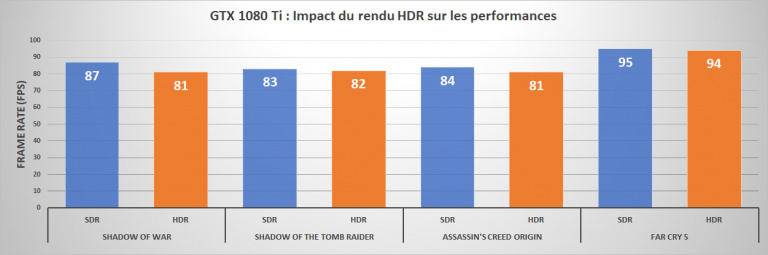

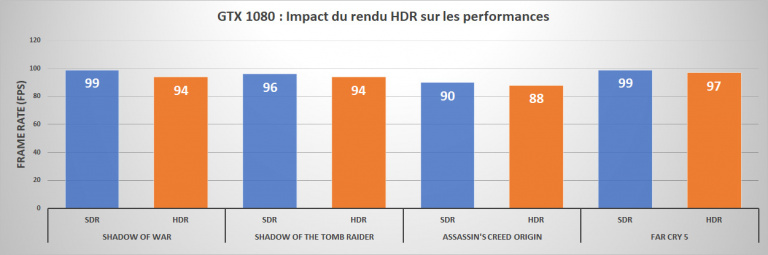

Maintenant que le décor est posé, revenons à ces fameux soucis de performances. Sont-ils toujours d'actualité ? Sur les cartes de série 10, oui, même si nos mesures n'ont pas permis de retrouver des décalages allant jusqu'à 10%. Toutefois, si l'on prend l'exemple de Shadow of War, la baisse de frame rate due à l'activation du rendu HDR varie de 5 à 7% tout de même. Sur le dernier opus de la série Tomb Raider, on est plutôt sur 1 à 2% de pertes. Enfin, chez Ubisoft, le frame rate d'Assassin's Creed Origin diminue de 3 à 4% avec le rendu HDR, tandis que Far Cry 5 limite la casse avec des chiffres en retrait de 1 à 2% seulement. Quoi qu'il en soit, la tendance est bel et bien là.

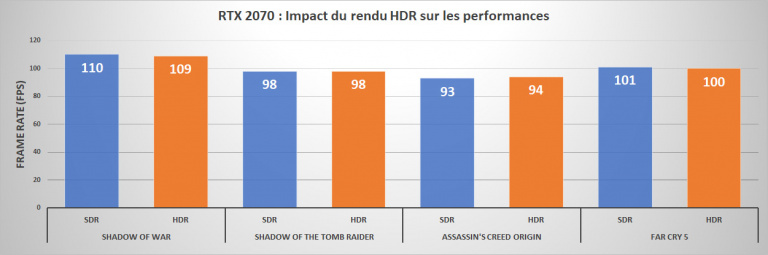

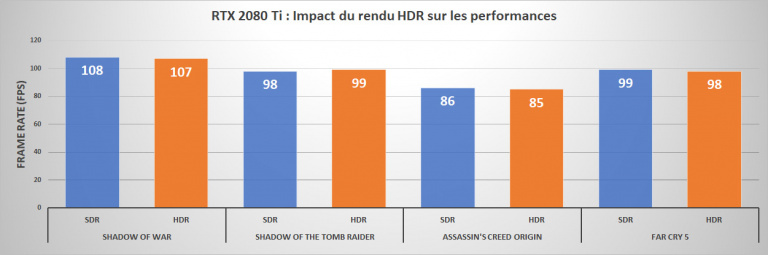

Côté RTX, on constate néanmoins que la situation s'améliore grandement. Les écarts sont inférieurs au pourcent, écarts dont on peut dès lors aisément arguer qu'ils rentrent dans notre incertitude de mesure. Le problème du HDR semble donc solutionné pour cette nouvelle génération Turing. En parallèle, nous avons profité de nos différents essais pour vérifier où en était le HDR, en termes de qualité de rendu. Notamment, nous avions à notre disposition un écran Asus ROG Swift PG27UQ. Or, notre précédente expérience s'était déroulée sur un afficheur Samsung C49HG90 doté d'un rétroéclairage Edge LED. Une technologie qui montre quelques limites lorsqu'il s'agit de reproduire une image HDR. L'écran ROG, quant à lui, intègre un rétroéclairage Full Local Dimming sur 384 zones, ainsi qu'une dalle Quantum-dot IPS.

Alors certes, le ROG Swift PG27UQ coûte la modique somme de 2500€. Mais voilà : il est bien plus représentatif de ce que le rendu HDR a à offrir, que l'écran Samsung. Exit la tendance à la surexposition que nous constations dans Far Cy 5, au placard l'aspect anormalement délavé d’Assassin’s Creed Origins ou de Shadow Warrior 2. Les quelques jeux que nous avons lancés nous ont fait bénéficier d'images absolument magnifiques, preuve que l'impact du rendu HDR reste pour beaucoup une affaire de qualité d'écran. Pour autant, il restait quelques impondérables dépendant des jeux ou de l'OS : par exemple Shadow of the Tomb raider n'active son mode HDR que sous DirectX 12. Une exception. On constate aussi toujours sous Windows des éléments de bureau qui apparaissent gris et non blancs. Et le mode HDR supporte encore très mal les overlays comme ceux appliqués par FRAPS, ou Afterburner.

Quoi qu'il en soit, retenez que si le HDR vous intéresse, les RTX apportent effectivement une gestion plus efficace de ce mode de rendu, même si on parlera ici plus de la correction d'une situation anormale que d'une véritable avancée technologique.